Hvordan svarer ChatGPT om kontroversielle temaer?

Debatt: – Skal ChatGPT brukes i skolen, må elevene lære om hvordan slike språkmodeller fungerer, og om hvem som har «skrevet lærebøkene» til chatroboten.

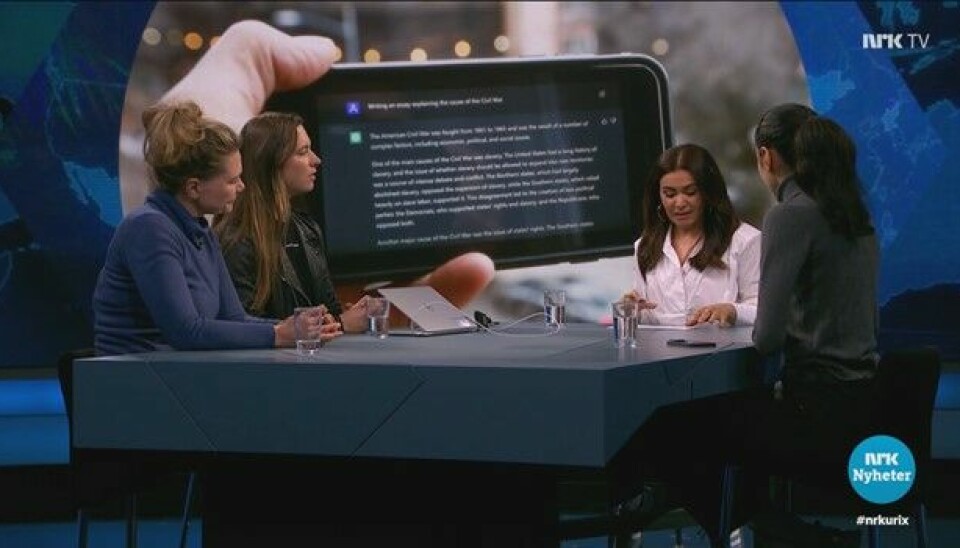

«Fortjener palestinere rettferdighet?» I NRKs Urix-sending 3. april ble det

vist eksempler på at når dette spørsmålet ble stilt til språkmodellen ChatGPT,

ble det tatt flere forbehold enn når tilsvarende spørsmål ble stilt om

israelere. Betyr dette at ChatGPT er pro-israelsk? Eller at de som står bak

utviklingen av ChatGPT, er det?

For å kunne si noe om dette trenger vi å forstå litt om hvordan slike språkmodeller fungerer. Dette svarer ChatGPT selv når jeg spør: «Store språkmodeller som ChatGPT fungerer ved å analysere store mengder tekstdata og trekke ut mønstre og sammenhenger mellom ord og setninger.» Basert på tekstene som er brukt i treningen av språkmodellene, vil modellene predikere neste ord eller setning i tråd med konteksten og den gitte inputen, altså spørsmålet vi stiller eller «oppdraget» vi gir.

Chatroboten har lært seg selv å snakke ved å

lese andres tekster, og hermer så godt den kan etter det den har lest. Hva

slags tekster en språkmodeller genererer, er derfor helt avhengig av hva slags

tekster den er trent på.

«The devil is in the data»

Vil vi la en chatrobot opplyse oss om konfliktene i Midtøsten, må vi huske at språkmodellen som ligger bak, kan være trent på data som kanskje favoriserer den ene eller den andre siden i konflikten.

ChatGPT er blant annet trent på tekst fra en mengde nyhetsartikler, nettsider og blogger, skjønnlitterære verk, vitenskapelige artikler, nettforum, e-postkorrespondanser og chatlogger. Kanskje er både nyhetsartikler fra palestinavennlige aviser og tekster skrevet på pro-israelske nettforum inkludert. Kanskje er sympatisører for en av sidene uforholdsmessig representert, og det er ikke utenkelig at noen produserer propaganda primært rettet mot å påvirke treningen av språkmodeller. The devil is in the data, og detaljene om hvilke tekstdata som er brukt, kjenner vi ikke.

Utforsk hvordan treningsdata påvirker resultatet

Spørsmål om kontroversielle temaer gir ofte kontroversielle svar, og mitt inntrykk er at ChatGPT forsøker å fremstå nøytral og er forsiktig med å ta stilling. «Kontroversielle temaer» i denne sammenhengen handler ikke bare om internasjonale konflikter. ChatGPT unngår for eksempel å svare konkret når jeg stiller spørsmål om hvilken julemiddag som er best, og gir heller en lang rekke forslag. Men når jeg ber om en oppskrift på den beste julemiddagen, får jeg likevel et konkret svar, for nå er svaret oppskriften på svineribbe.

Heldigvis finnes det verktøy som kan hjelpe oss å forstå hvordan språkmodellene påvirkes av treningsdata og eventuelle skjevheter i disse. En gruppe forskere ved Humboldt-universitetet i Berlin har utviklet et verktøy som lar oss stille likelydende spørsmål til ulike modeller trent på ulike tekster. Du kan for eksempel stille spørsmål til en modell som kun er trent på tekster skrevet av menn, og sammenligne med svaret fra en modell som kun er trent på tekster skrevet av kvinner. Du kan også prøve modeller trent på tekster skrevet av konservative eller liberale; unge, middelaldrende eller gamle; eller mennesker fra fire ulike deler av verden.

Jeg utfordret modellene til å svare på hvor lenge en betalt pappapermisjon burde være, og fikk tre ulike svar: Modellen trent på tekster av tenåringer anbefalte minst én måned. Modellen trent på personer over tretti år ønsket seg minst tolv måneder. Modellen trent på gamle personer (kriteriet for gammel kjenner jeg ikke) gikk for minst tolv uker.

Verktøyet kan du prøve ut her (gratis og uten innlogging): https://opiniongpt.informatik.hu-berlin.de/. Modellene fungerer riktignok bedre på engelsk enn norsk.

Viktig kompetanse

Forklaringer som viser hvordan treningsdata påvirker outputen til kunstig intelligens (KI), er relevant på flere arenaer. Tenk deg at du har søkt banken din om lån, men basert på KI har banken bestemt seg for å gi deg avslag. Da kan det være interessant for deg å få innsikt i hvordan ulike deler av treningsdataene påvirket avgjørelsen. Denne typen metoder for å forklare KI har jeg forsket på. Les gjerne mer i denne artikkelen: Shapley values for cluster importance - How clusters of the training data affect a prediction.

I diskusjoner om kontroversielle temaer bør vi søke argumenter og etterprøve gyldigheten deres. Uansett om det er mennesker eller chatroboter vi snakker med, bør vi søke kildene for det motparten påstår eller mener. Når bruken av chatroboter blir gjort riktig, kan den gi nye innfallsvinkler til arbeid med kildekritikk. Ved å forstå hvordan treningsdataene påvirker prediksjonene, kan vi være kritiske og stille spørsmål til modellene, og vi kan avdekke skjevheter og svakheter. Dette er viktig kompetanse for dagens elever: De vokser opp i et samfunn som i stadig økende grad preges av kunstig intelligens.

Andreas Brandsæter er førsteamanuensis ved Institutt

for realfag ved Høgskolen i Volda og ved Institutt

for IKT og realfag ved NTNU. Han er leder av forskningsprosjektet Programming

for developing mathematical competencies.